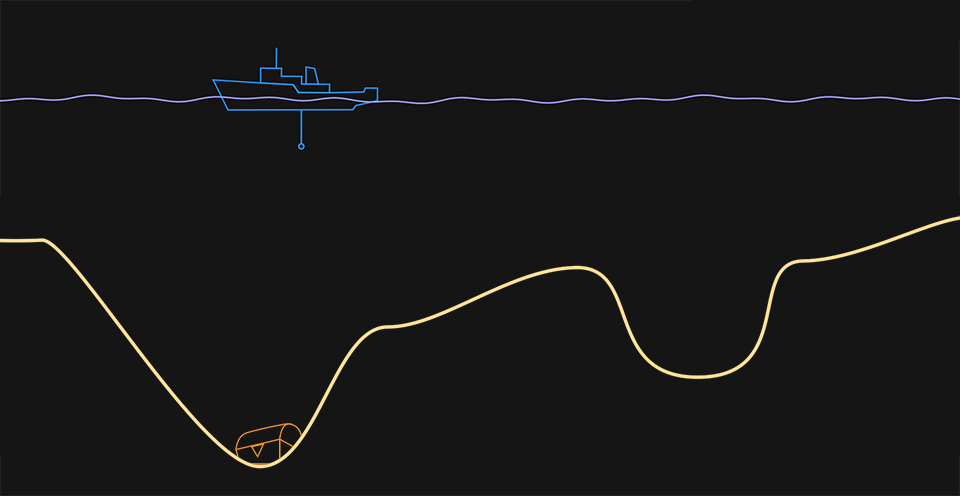

Finde den Schatz, der am tiefsten Punkt des Meeresbodens versteckt ist, indem du eine Bodensonde vom Forschungsschiff losschickst. Mit den Pfeiltasten bewegst du das Schiff, mit dem runden Knopf schickst du die Sonde ab.

Wenn du den Schatz gefunden hast, dann lies unten weiter. Du erfährst, wie dieselben Strategien, die dich zum Schatz führten, auch von KIs verwendet werden.

Nachdem du das Spiel ein paar Mal gespielt hast, ist dir wahrscheinlich folgendes aufgefallen: Man findet den tiefsten Punkt des Meeresbodens am schnellsten, wenn man das Gefälle beachtet: wie steil war es an den untersuchten Stellen? In welche Richtung war der Boden geneigt? Auch wenn du nicht den kompletten Boden siehst, verrät dir das Gefälle, wo du am besten weitersuchst.

Wenn du diese Strategie zur Schatzsuche anwendest, dann lernst du genauso wie eine KI – nämlich durch einen Algorithmus namens Gradientenverfahren. In Englisch heißt er, wie unser Spiel, Gradient Descent.

In unseren beiden Pfaden Piano Genie und Neural Numbers kannst du dir anschauen, wie Neuronale Netze lernen. Wir geben dem Netz ein Beispiel, zu dem es einen Output generiert. Dann analysieren wir, wie gut oder schlecht es war, und geben dem Netz Feedback dazu. Das Netz korrigiert seine Antwort, und wir versuchen es erneut.

Schauen wir uns diesen Prozess genauer an. Nachdem das Netz den Output generiert hat, messen wir, wie weit es vom gewünschten Ergebnis entfernt war. Diese Entfernung nennen wir “Fehler”. Das Neuronale Netz verbessert sich in seiner Aufgabe, indem es die Stärke der Verbindungen zwischen den künstlichen Neuronen so verändert, dass der Fehler möglichst klein für alle möglichen Inputs wird. Dies entspricht der Suche nach der tiefsten Stelle in unserem Spiel. Jeder Schritt der Trainingsphase (Eingabe des Inputs, Outputkontrolle, Fehlermessung, Anpassung des Netzes) braucht etwas Zeit, und muss tausendmal oder sogar Millionen Mal wiederholt werden. Idealerweise finden wir einen schnellen Weg, um den Fehler zu minimieren. Das Netz benutzt – so wie du – das Gefälle, um zu entscheiden, wie es die Neuronenverbindungen anpasst, und die Suche fortführt.

Lokales Minimum

Bei der Schatzsuche tritt eine Schwierigkeit auf, die ebenfalls ein Problem beim Trainieren von KIs ist. Mit ein wenig Glück findest du den tiefsten Punkt, indem du dem Gefälle des Meeresbodens folgst. Hast du allerdings kein Glück, findest du nur einen Punkt, der durch einen oder mehrere Berge vom wirklich tiefsten Punkt getrennt ist. Du landest zwar in einer tiefen Stelle, findest aber nicht die tiefste des gesamten Meeresbodens. Wir nennen das ein “lokales Minimum”.

Wenn du auf der linken Seite des Bildschirms mit der Suche beginnst, findest du den tiefsten Punkt und damit den Schatz. Wenn du aber auf der rechten Seite anfängst zu suchen, findest du stattdessen womöglich nur das lokale Minimum.

Wenn ein Neuronales Netz ein lokales Minimum findet, steckt es fest und kann nicht weiter lernen. Zuvor ist es dem Gefälle gefolgt und hat seine neuronalen Verbindungen immer ein wenig angepasst, um sich weiter zu verbessern. Jetzt aber bleibt es auf dem erreichten Leistungsniveau, weitere Anpassungen können das Ergebnis nun nicht mehr verbessern, teilweise verschlechtern sie es sogar. Das kann frustrierend sein. In der realen Welt können Neuronale Netze ihre Aufgaben häufig gar nicht perfekt bewältigen. Dafür gibt es keine Garantie. Existiert womöglich gar kein Schatz?

Um aus einem lokalen Minimum herauszukommen, gibt es eine Strategie, die du vielleicht auch schon im Spiel angewendet hast: Versuche etwas anderes, wähle einen neuen Startpunkt und suche nochmal neu. KIs kombinieren das systematische Gradientenverfahren mit einer Prise Zufall. Das abzusuchende Höhenprofil könnte ziemlich steinig sein, mit vielen Höhen und Tiefen. Um das herauszufinden, braucht man mehr als ein paar Sonden.

Wir werden ein größeres Boot brauchen

Es gibt einen markanten Unterschied zwischen unserem Spiel und der Fehlerminimierung von Neuronale Netzen. Unser Boot kann nur nach links oder rechts fahren, weil das Spiel in 2D ist (das Boot bewegt sich in der ersten Dimension, die Sonde in der zweiten). Du kannst Dir wahrscheinlich vorstellen, wie das Ganze in unserer realen dreidimensionalen Welt funktioniert: das Boot kann sich in zwei Dimensionen bewegen (Nord-Süd und Ost-West) und Sonden in die dritte Dimension aussenden. Der echte Meeresboden ist auch keine einfache Kurve, sondern eine Fläche mit Bergen und Tälern, also eine Art Gebirge. Das Gefälle kann man sich trotzdem zunutze machen (stell dir vor, wie eine Kugel hinunterrollen würde), um den tiefsten Punkt oder ein lokales Minimum zu finden.

Neuronale Netze suchen auch nach dem tiefsten Punkt in höherdimensionalen Gebirgen. Diese können wir dann nicht mehr darstellen oder uns vorstellen, aber wir können über sie nachdenken. Für die zwei Dimensionen, in denen sich ein Schiff bewegt, könnte man beispielsweise sagen “gehe 1 Kilometer nach Norden und 2 Kilometer nach Osten und suche dort weiter”, bei tausend Dimensionen müssen dann tausend Zahlenwerte angegeben werden, wie man zum nächsten Suchpunkt gelangt. Die Mathematik dahinter bleibt dieselbe, man kann also mit demselben Verfahren auch von einem tausenddimensionalen Gebirge das Gefälle an einem Punkt berechnen und aus dieser Information den nächsten Suchpunkt bestimmen – mit denselben Problemen wie im zweidimensionalen Fall.

Du kannst dir jetzt wahrscheinlich vorstellen, warum KI ziemlich schnelle Computer braucht. Selbst sie benötigen dann mit den effizientesten Suchstrategien aber trotzdem noch Tage, Wochen oder länger, um ein neuronales Netz zu trainieren.

Einige Punkte zum Nachdenken

Der Lernprozess kombiniert die Anpassung des Neuronalen Netzes, um Ergebnisse zu optimieren, mit Strategien, wie man aus einem lokalen Minimum herauskommt. Dieser Prozess hat viele Parallelen im echten Leben. Professionelle Athlet*innen ändern manchmal ihre Technik, um noch bessere Ergebnisse zu erzielen (der Profigolfer Tiger Woods änderte seinen Golfschlag einige Male in seiner Laufbahn, ohne die Gewissheit, dass er sich dadurch verbessern würde). Professionelle Sänger*innen benötigen manchmal Coaching, um ihre Stimmtechnik zu ändern und dadurch Schäden an den Stimmbändern zu vermeiden. Tiervölker treffen manchmal die riskante Entscheidung auszuwandern, um mehr Nahrung oder eine bessere Umgebung zu finden. Vielleicht gelingt es dir mit dieser Strategie sogar, die beste Kombination an Eissorten zusammenzustellen.

- Fallen dir andere Möglichkeiten ein, wie der Lernprozess von KIs den intelligenten Entscheidungen von Lebewesen ähnelt?

- Risiko und Zufall werden in der Entscheidungsfindung manchmal mit Unvernünftigkeit gleichgesetzt. Wie können wir beides als nötige Zutaten für intelligente Entscheidungsprozesse verstehen und akzeptieren?

Der Text ist unter der Lizenz Creative Commons Attribution License verfügbar. Gradient Descent is Teil von i-am.ai und wurde von IMAGINARY entwickelt.